机构名称:

¥ 1.0

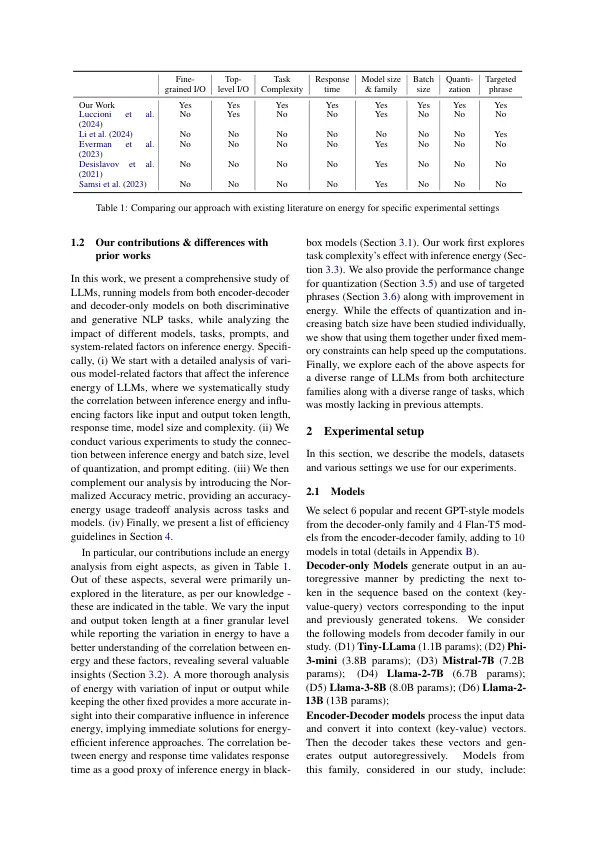

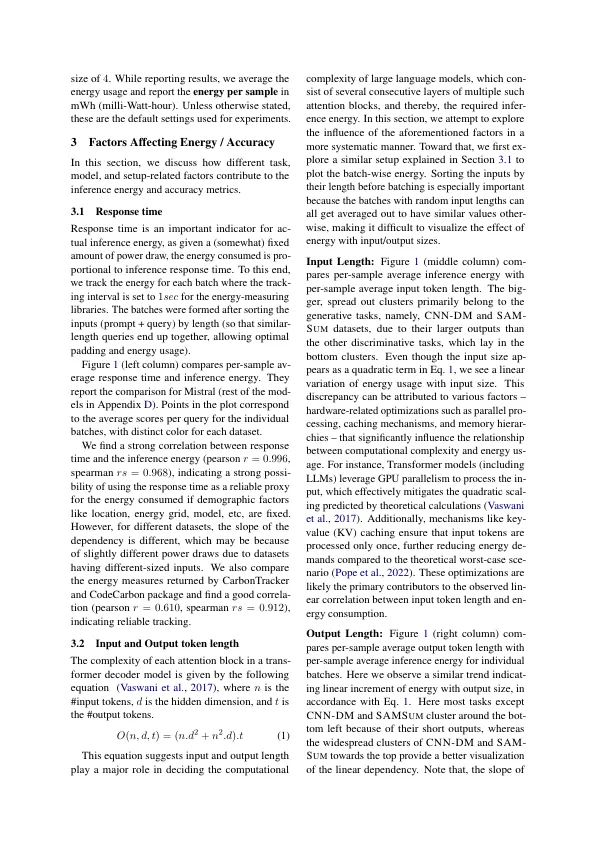

大型语言模型(LLMS)因其在各种任务中具有出色的属性和多功能性而被越来越多地认可。但是,与这些模型相关的高推理成本尚未得到关注,尤其是与现有研究中培训成本的关注相比。响应这一差距,我们的研究在广泛的NLP任务中对LLM推断能量进行了全面的基准测试,我们在其中分析了不同的模型,任务,提示和系统相关因素对推理能量的影响。具体来说,我们的经验揭示了几个有趣的见解,包括将推理能量与输出令牌长度和响应时间的密切相关。此外,我们发现量化和最佳批量大小以及针对性的及时短语可以显着降低能量使用。这项研究是第一个在各种各样的各个方面进行彻底基准的LLM,从而提供了见解并提供了一些提高模型部署能源效率的建议。

对表示漏洞和工程强大的视觉变形金刚的机械理解

主要关键词

![机械工程理学士 [制造工程]](/simg/5/563b5a99f32203cfc4a9c28013d261956ddb0088.webp)